Il dibattito sulla responsabilità nell’uso dell’Intelligenza Artificiale

La nuova immagine di TIM

Una nuova immagine con uno stile dinamico, colori moderni e persone che occupano quasi interamente la scena. Scopri di più

Risultati Preliminari FY 2024 e aggiornamento Piano Strategico

Approfondisci

La Sostenibilità per TIM

Il Report 2024 accoglie i principi della Corporate Sustainability Reporting Directive (CSRD) ed è incluso nella Relazione Finanziaria e di Sostenibilità. Approfondisci

Ultimi Comunicati Stampa

Leggi gli ultimi comunicati stampa e naviga nell'archivio dell'Ufficio Stampa del Gruppo TIM. Leggi i comunicati

Scarica il PDF

Dibattito responsab ...

1737 KB

Tutti i prodotti, compresi programmi ed applicazioni software, devono essere associati ad una responsabilità per i danni che possono causare a seguito di malfunzionamenti. Il tema della responsabilità risulta particolarmente complesso per i sistemi di Intelligenza Artificiale (IA): chi risponde infatti per un’azione dannosa a seguito di decisioni di un sistema di IA? La causa del danno deriva da dati errati su cui si è basata la decisione di IA, da un malfunzionamento dell’algoritmo, da un uso improprio del sistema o da una sua evoluzione non prevista? Quando un sistema di IA generativa genera testo, audio o immagini a partire da elementi protetti da diritto d’autore si tratta di semplice ispirazione o di violazione di copyright? I sistemi basati sull’Intelligenza Artificiale devono necessariamente gestire in modo appropriato la questione per poter godere della fiducia degli utilizzatori e dare avvio ad un pieno sviluppo ed utilizzo della tecnologia in diversi campi, compreso quello delle telecomunicazioni, e per innumerevoli applicazioni a beneficio di cittadini, imprese e amministrazione pubblica. Il concetto è esplicitamente riconosciuto dalla Commissione Europea nella relazione sulle implicazioni dell’Intelligenza Artificiale [1], dove è sottolineata l’importanza di un quadro chiaro in materia di sicurezza e di responsabilità.

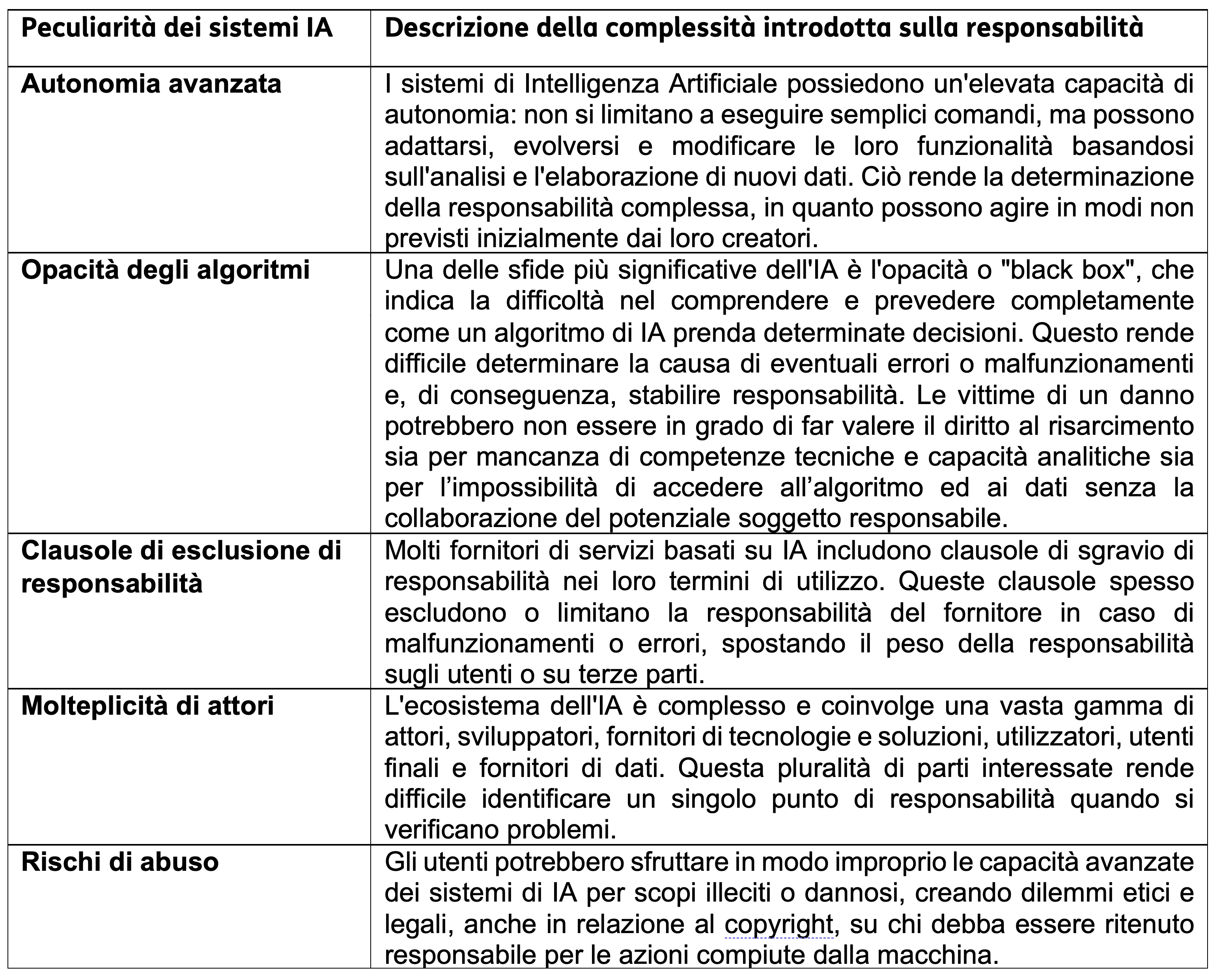

Vi sono alcune caratteristiche intrinseche dei sistemi di Intelligenza Artificiale che rendono particolarmente complesse la comprensione delle possibili cause di un danno e l’applicazione in generale delle norme sulla responsabilità. Di conseguenza le vittime di danni causati dai sistemi di IA potrebbero andare incontro a difficoltà e costi nel risalire alla causa del danno per il quale richiedere il risarcimento e nel dimostrarlo, rischiando quindi di non essere adeguatamente risarcite. I sistemi di Intelligenza Artificiale presentano sfide uniche in termini di responsabilità che emergono principalmente dalle peculiarità rappresentate in Tab.1 relative a: autonomia avanzata, opacità degli algoritmi, clausole di esclusione di responsabilità, molteplicità di attori, rischi di abuso.

Tabella 1: Principali caratteristiche dei sistemi di Intelligenza Artificiale che aggiungono complessità al risarcimento per danni subiti

Stabilire delle garanzie in caso di danni e problemi derivanti dall’utilizzo di sistemi basati sull’Intelligenza Artificiale contribuisce a creare un clima positivo sia per gli investimenti da parte dell’industria, sia per l’adozione della tecnologia da parte di cittadini ed imprese. Secondo un sondaggio svolto da Ipsos Belgium e iCite per la Commissione Europea [2], pubblicato a luglio 2020, la responsabilità per i danni causati dall’IA rappresenta uno dei principali ostacoli esterni per le imprese europee nel proprio contesto di business e, restringendo il campo alle sole imprese che non hanno ancora adottato soluzioni di IA, è ritenuta il primo ostacolo in assoluto. In particolare, come mostrato in Fig.1, costituiscono una sfida importante nell’adozione dell’IA da parte delle imprese ostacoli di tipo finanziario ed a livello di standardizzazione tecnica per lo scambio dei dati oltre che ostacoli legali legati in particolar modo alla responsabilità dei danni.

Figura 1: Principali ostacoli esterni alle aziende nell’uso dell’Intelligenza Artificiale in UE secondo lo studio Ipsos-ICite “European enterprise survey on the use of technologies based on Artificial Intelligence”

In ambito europeo sono state avviate da alcuni anni e sono tuttora in corso iniziative legislative mirate a stabilire un quadro armonizzato di norme, con l’obiettivo di favorire l’evoluzione tecnologica garantendo al contempo il rispetto dei diritti degli individui. In particolare, per far fronte alle sfide derivanti dalla diffusione dell’Intelligenza Artificiale, è stato proposto dalla Commissione Europea ad aprile 2021 un nuovo regolamento sull’Intelligenza Artificiale, denominato AI Act, che mira a prevenire i danni e ridurre i rischi garantendo a cittadini ed imprese sicurezza e fiducia nell’utilizzo dell’IA grazie a regole flessibili e proporzionate a seconda dei rischi specifici posti dai sistemi di IA [3]. Considerato che le regole dell’IA Act, seppur mirate a minimizzare i rischi, non consentiranno di eliminare completamente i danni causati dall’uso di sistemi di IA, sono parallelamente in corso attività specifiche in tema di responsabilità per la revisione e l’adeguamento del quadro legislativo esistente. Le norme attuali sono basate da un lato sull’applicazione della direttiva sulla responsabilità per danno da prodotti difettosi [4] che risale a quasi 40 anni fa e che regola a livello europeo la responsabilità oggettiva del produttore di prodotti difettosi, e dall’altro sull’applicazione di norme nazionali sulle azioni e verifiche necessarie da parte del danneggiato per ottenere il risarcimento. Tale attività di adeguamento delle norme sulla responsabilità ha portato all’adozione da parte della Commissione Europea a settembre 2022 di due proposte legislative attualmente in discussione presso le istituzioni europee [6]:

Quest’ultima proposta legislativa è espressamente legata alla responsabilità per i sistemi di Intelligenza Artificiale e mira ad armonizzare a livello europeo le norme sulla responsabilità civile extracontrattuale con l’obiettivo di rafforzare la fiducia nella tecnologia e garantire un regime di responsabilità efficiente in cui le richieste di risarcimento siano onorate. Sul fronte economico sono promessi sostanziali benefici, con un potenziale aumento del valore del mercato dell’IA compreso tra 500 milioni e 1,1 miliardi di euro [8].

La concezione, l’utilità e l’utilizzo, nonché la regolamentazione dei sistemi di Intelligenza Artificiale sono profondamente diversi a seconda dei paesiì del mondo, determinati da logiche storiche e geopolitiche. Cina e Stati Uniti si trovano oggi agli antipodi di un possibile spettro normativo che simboleggia il modo di regolamentare l’Intelligenza Artificiale, mentre l’Unione Europea cerca di offrire una soluzione in termedia [11].

In Cina la tecnologia è sottoposta al controllo statale, ed è alla base di interessi primariamente economici e geopolitici: il governo cinese ha recentemente introdotto la necessità per le imprese di ottenere licenze specifiche nel momento in cui queste vogliano fornire servizi utilizzando IA generativa, ed offrire garanzie di integrità, sicurezza e ordine [12]. Il Governo intende assicurarsi che le informazioni generate dalle IA siano compatibili con i suoi interessi, ma non sembra voler frenare questo progresso, al contrario mira ad utilizzarlo strategicamente per potenziare la propria importanza a livello commerciale e tecnologico. In tema di responsabilità vi sono state discussioni sulla natura giuridica dell’IA, volte a valutare se trattasi effettivamente di un prodotto, cioè un bene commercializzato sul mercato e quindi soggetto alla normativa cinese sulla responsabilità per prodotti difettosi. In tal caso, l’onere della prova sarebbe a carico del ricorrente, che dovrebbe provare il difetto del prodotto, e dell’eventuale danno risponderebbe, per responsabilità oggettiva, il produttore [13]. Questa interpretazione è abbastanza vicina a quella europea, ma non considera la difficoltà, per l’utente finale, di provare il malfunzionamento del sistema di IA da lui utilizzato.

Negli USA, la tendenza è stata quella di evitare una regolamentazione diretta dell’IA attraverso normative centrali. Anche se predomina un sentimento di regolamentazione minima a livello federale, alcune agenzie come la Federal Trade Commission (FTC) hanno assunto un approccio proattivo verso specifiche sfide dell’IA, concentrandosi specialmente sulla trasparenza e sulle pratiche ingannevoli che influenzano i consumatori, in particolare nelle loro decisioni finanziarie. La FTC punta a sanzionare le imprese che forniscono informazioni fuorvianti sui loro prodotti [14] , intervenendo ex-postnel mercato anziché attraverso normative preventive. In assenza di un quadro federale completo, i singoli Stati hanno affrontato singolarmente temi regolamentari legati all’IA. Questo approccio si è tradotto in un panorama normativo diversificato e frammentato: proprio ciò che l’UE intende evitare. Ad esempio, la città di New York impone verifiche sui pregiudizi per gli strumenti automatizzati di decisione sull’assunzione di personale, mentre in Colorado vigono leggi che proteggono dalle pratiche assicurative sleali guidate dall’IA. Si evidenzia tuttavia che negli Stati Uniti, in ambito istituzionale a livell o federale, sono state recentemente avviate iniziative ed azioni volte ad uno sviluppo ed utilizzo responsabile dell’IA a tutela dei cittadini e contro ogni discriminazione [15] ed il paese si sta mostrando incline a lavorare in modo collaborativo sull’IA, con una tendenza crescente ad allinearsi agli approcci internazionali, in particolare dell’Unione Europea.

La diffusione di sistemi basati sull’Intelligenza Artificiale pone nuove sfide anche in termini di responsabilità, considerato che alcune peculiarità dell’Intelligenza Artificiale comportano maggiore difficoltà e complessità per il risarcimento dei danni causati dalla tecnologia. Il tema deve essere affrontato in modo da garantire lo stesso livello di protezione concesso in caso di danni relativi a tecnologie tradizionali ed allo stesso tempo ci siano le condizioni per lo sviluppo e l’innovazione tecnologica.

Nel contesto innovativo di impiego sempre più spinto dell’Intelligenza Artificiale, la Cina segue un approccio fortemente basato su un controllo statale ex ante, mentre gli USA un approccio basato su interventi ex-post e su regole frammentate per i singoli stati. In Europa si punta a trovare un equilibrio tra la protezione dei cittadini dai rischi legati all’IA e la promozione dell’innovazione da parte delle imprese; tramite l’elaborazione di un quadro legislativo armonizzato specif ico per l’IA, che preveda anche una revisione delle norme in materia di responsabilità, si mira a favorire lo sviluppo e l’impiego della tecnologia nei diversi settori compreso quello delle telecomunicazioni.